Unidad 5 Cadenas de Markov YouTube

Previamente, se enumeran algunas definiciones que clasifican los estados de una cadena. Para ello consideraremos el ejemplo que utilizamos para introducir una Cadena de Markov en Tiempo Discreto, asumiendo la probabilidad de lluvia al inicio (y final del día) en un 20% (p=0,2). El grafo que resume las probabilidades de transición es el siguiente:

Ejercicio resuelto de las cadenas de Markov YouTube

El inmueble de Markov implica también que el tiempo de tenencia en un estado tiene la propiedad sin memoria y así debe tener una distribución exponencial, una distribución que conocemos bien. En términos de lo que quizás ya hayas estudiado, el proceso de Poisson es un ejemplo sencillo de una cadena de Markov en tiempo continuo.

Cadenas de Markov

Otro fenómeno interesante es el de Random walk, que de nuevo es una Cadena de Markov. Consideremos la caminata aleatoria, como se muestra arriba, es decir, el movimiento de un paso hacia adelante desde cualquier estado puede ocurrir con una probabilidad py el movimiento hacia atrás de un paso puede ocurrir con una probabilidad q. Aquí el.

Cadenas de Markov simplemente explicadas

Una cadena de Markov es un sistema que cambia de un estado a otro de acuerdo con probabilidades dadas. La tabla de probabilidades se llama matriz de transición, y la lista de probabilidades de que el sistema se encuentre en un estado determinado después de cierto número de pasos se llama vector de estado. Si P es la matriz de transición y v.

Clasificacion de estados cadenas de markov YouTube

Hay ciertas cadenas de Markov que tienden a estabilizarse a largo plazo. Los examinaremos más a fondo más adelante en este capítulo. La matriz de transición que hemos utilizado en el ejemplo anterior es justamente una cadena de Markov. El siguiente ejemplo trata sobre la tendencia a largo plazo o situación de estado estacionario para esa.

Cadenas de markov tiempo discreto ejemplo 2 YouTube

Clase 23. Aplicaciones: Cadenas de Markov. Clase 23. Aplicaciones: Cadenas de Markov. 1. Cadenas de Markov. Una cadena de Marvok es un proceso evolutivo que consiste de un número finito de estados en cual la probabilidad de que ocurra un evento depende solamente del evento inmediatamente anterior con unas probabilidades que están fijas.

ES501 Intro Cadenas de Markov YouTube

Cadena de Markov. La cadena de Markov, también conocida como modelo de Markov o proceso de Markov, es un concepto desarrollado dentro de la teoría de la probabilidad y la estadística que establece una fuerte dependencia entre un evento y otro suceso anterior. Su principal utilidad es el análisis del comportamiento de procesos estocásticos.

Introduccin Las cadenas de markov son modelos probabilsticos

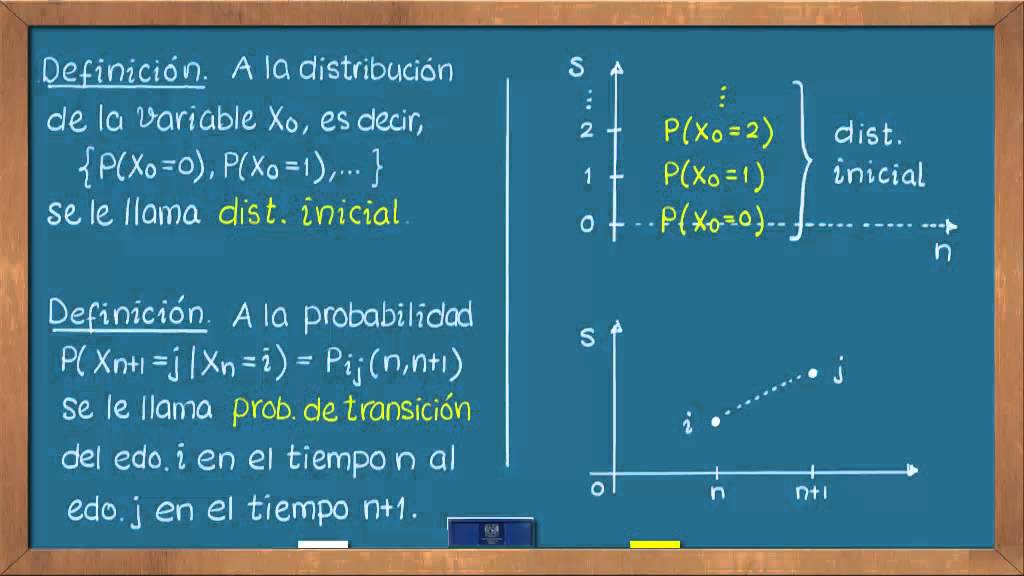

Definición. En matemáticas, una Cadena de Markov es un proceso estocástico a tiempo discreto {: =,,.} con espacio de estados discreto que para cualquier entero y para cualesquiera ,,., + satisface [+ = + | =, =,., =] = [+ = + | =]a esta propiedad se le conoce como propiedad de Markov.. Características Cadenas homogéneas y no homogéneas. Se dice que una Cadena de Markov es.

Cadenas Markov Matriz de Probabilidad de 1 Transición YouTube

Una cadena de Markov es una serie de eventos, en la cual la probabilidad de que ocurra un evento depende del evento inmediato anterior. En efecto, las cadenas de este tipo tienen memoria, "Recuerdan" el último evento y esto condiciona las posibilidades de los eventos futuros. Esta dependencia del evento anterior distingue a las cadenas de.

Ejercicio 2 Cadenas de Markov Matemáticas Ciencia y Tecnología

Ejemplos de la cadena de Markov. El proceso o cadena de Markov es intuitivo y accesible, esto se debe a que se puede implementar en modelos probabilísticos y en técnicas de ciencias de datos, sin utilizar conceptos matemáticos o estadísticos. Gracias a sus propiedades, es una herramienta que se puede usar en campos como estadística, la.

Ejercicios 57 y 59. Cadenas de Markov. YouTube

Un proceso estocástico en tiempo discreto se denomina una Cadena de Markov en tiempo discreto si y solo sí se satisface la Propiedad Markoviana (esto es básicamente que el futuro t=n+1 es independiente del pasado dado el presente t=n) y Propiedad Estacionaria (la probabilidad de pasar de un estado i a un estado j al cabo de una etapa no depende de la etapa n).

Cadenas de Markov ejercicio resulto con Rstudio YouTube

El estado inicial X0 X 0 tiene una distribución de probabilidad arbitraria. Una cadena de Markov de estado finito es una cadena de Markov en la que S S es finita. Ecuaciones como\ ref {3.1} suelen ser más fáciles de leer si se abrevian como. Pr{Xn ∣ Xn−1,Xn−2,.,X0} = Pr{Xn ∣ Xn−1} Pr. .

Cadenas de Markov Matriz de Probabilidades de n Transiciones YouTube

Las cadenas de Márkov. De manera intuitiva, una cadena de Márkov en tiempo discreto (por sencillez) es un proceso estocástico que evoluciona en tiempo discreto o etapas y tiene la propiedad.

Análisis de Markov Cadena Markov Probabilidad

Desarrollado por Andrei Andreevich Markov, una cadena de Markov es un modelo que simula los resultados de múltiples eventos en una serie. Las cadenas de Markov dependen de probabilidades conocidas entre estados. Un estado es cualquier resultado potencial de un evento, y la probabilidad de que un estado pase a otro estado se basa en el.

0630 ¿Qué es una cadena de Markov? YouTube

Cadena de Márkov. Una cadena de Markov o proceso de Markov es un modelo estocástico que describe una secuencia de posibles eventos en los que la probabilidad de cada evento depende únicamente del estado alcanzado en el evento anterior. Una secuencia infinita numerable, en la que la cadena cambia de estado en pasos de tiempo discretos, da una.

Investigación de Operaciones II Cadenas de Markov (continuación)

Este video es una introducción al tema de cadenas de Markov.Ofrece las definiciones iniciales e ilustra qué es un Estado y cómo construir una Matriz de Trans.